https://fenzhan.tistory.com/50

1. LLM은 인과 관계를 이해하고 추론할 수 있을까?

Large Laguage Model(LLM)은 방대한 텍스트 데이터를 바탕으로 학습해 언어 이해와 생성에서 좋은 능력을 발휘한다.이러한 LLM의 Model Understading에 대한 최신 연구에 따르면, 인과적 질문(Causal Question)에

fenzhan.tistory.com

이전 글에서 LLM은 불완전한 도메인 전문가로, 학습된 패턴을 바탕으로 인과 관계와 관련된 구조나 관계에 대한 힌트를 주는 역할을 할 수 있다고 하였다. 그렇다면 어떻게 LLM을 활용하여 Causal Discovery(CD)를 수행하고, 이를 산업 애플리케이션에 적용할 수 있을까? 이러한 질문에 어느 정도 답변을 준 NeurIPS 2024 Poster에 게재된 COAT(Causal representatiOn AssistT)이라는 논문을 중점으로 본 리뷰를 하고자 한다.

성능이 좋은 CD를 수행하기 위해서는 도메인 전문가가 제공하는 피드백에 의존할 수 밖에 없다. 이러한 문제는 CD를 수행하는 독립성 테스트를 중심으로 한 마르코브 동등성 클래스(Markov Equivalence Class)에서 생성되는 CPDAG로 인한 문제일 수도 있으며, CD 알고리즘 자체에서 발생하는 문제일 수도 있다. 따라서 때로는 도메인 전문가의 피드백은 CD의 성능에 많은 영향을 끼치기도 한다. 하지만 이러한 도메인 전문가에게 정보를 얻고, CD를 강화하는 것에는 비용이 든다. 또한 도메인 전문가를 활용하여 하나하나 그래프의 관계성을 검토하는 것은 사실상 실무에서 불가능한 일이다.

최근 등장한 대규모 언어 모델(LLM)은 이러한 격차를 완화할 수 있는 새로운 기회를 제공한다. 방대한 인터넷의 텍스트 데이터를 통해 훈련된 LLM은 자연어를 이해하고 풍부한 지식을 활용하여 다양한 일반 작업을 해결하는 데 있어 인상적인 능력을 보여주고 있다.

그렇다면 LLM이 현실 세계의 인과적 메커니즘을 밝히는 데 어떻게 안정적으로 도움을 줄 수 있을까?

COAT의 저자들은 위의 질문으로 글을 시작한다. COAT에서는 고객 리뷰나 의료 진단에 대한 인과 관계 발견에 초점을 맞춰 해당 질문에 답하고, 실증적인 평가를 한다.

COAT 프레임워크의 핵심은 텍스트와 같은 비정형 데이터에서 구조화된 변수로 LLM을 활용하여 변환시키며, 목표 변수의 Makrov Blanket을 찾는 것이다. 아래 문제 정의를 보자.

데이터

고객의 별점이나 환자의 종양 유형 등 목표 변수(Target Variable) Y가 주어진다. 이때 비정형 데이터(고객의 리뷰나 종양 이미지)는 X로 표기된다. 데이터셋 D는 (X, Y)의 분포에서 독립적으로 추출된 n개의 샘플로 구성된다. X와 Y사이의 관계는 사전 가정은 없다.

LLM의 역할

LLM의 역할은 비정형 데이터 X에서 정보를 추출하는 역할을 한다. h는 여러 요소 V = {w_1,w_2,…,w_k}의 집합으로 분해될 수 있으며, 여기서 각 요소 w_k는 비정형 데이터 X를 미리 정의된 값 공간 C (예를 들어, 텍스트라면 긍정/부정 점수 : -1, 0, 1, 이미지 데이터라면 "밝기", "색상", "텍스처" 등)로 매핑하는 함수 w_i:X↦C 이다. 즉, 비정형 데이터 X는 LLM을 통해서 아래와 같이 재구성 된다.

즉, LLM이 하는 일은:

- 비정형 데이터를 정형화된 특징들 wk(X) 로 변환하고

- 이러한 특징을 모아서 유의미한 표현 Z를 구성하는 것.

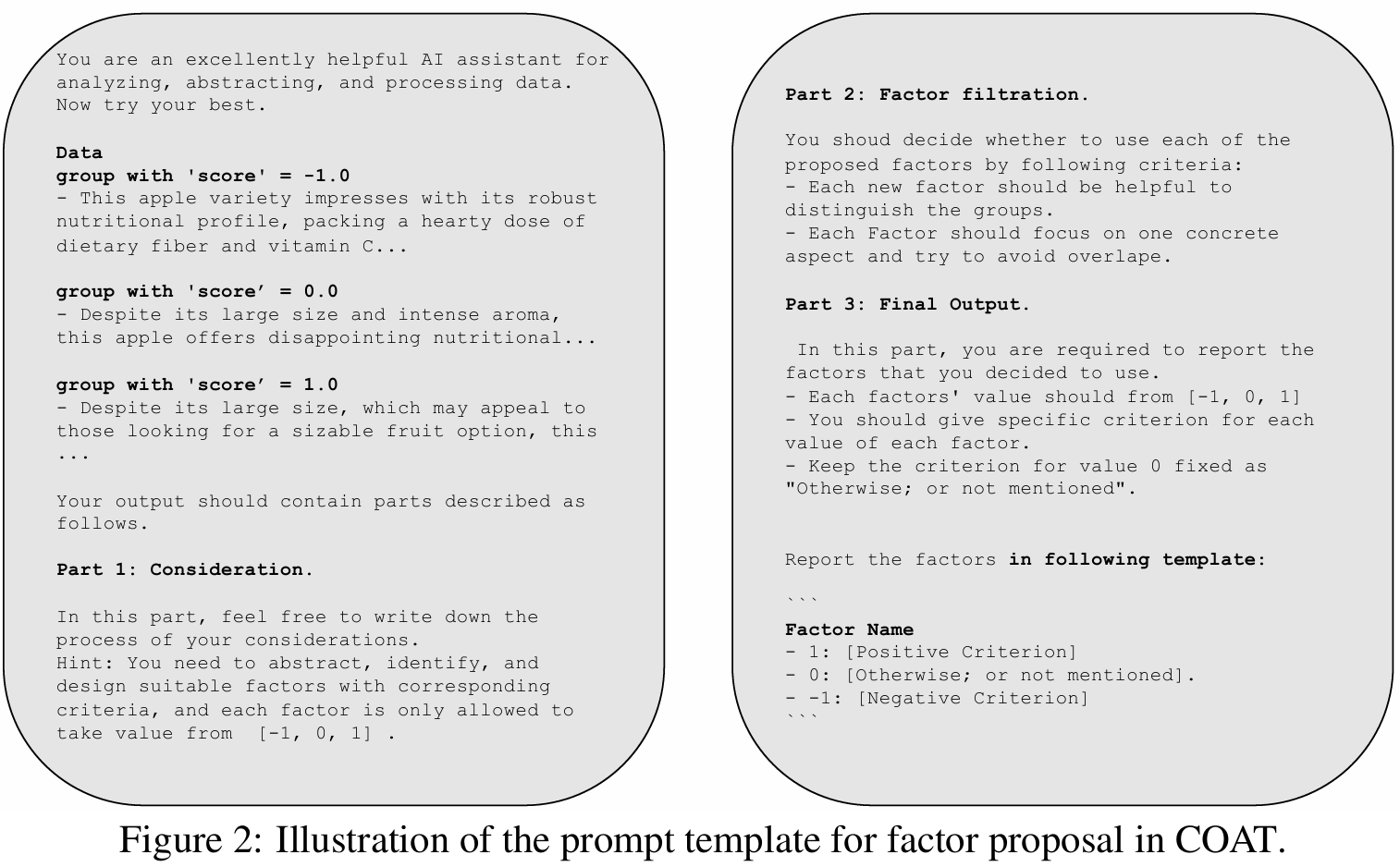

논문에서 소개한 COAT 프레임워크는 크게 (a) Factor Proposal, (b) Factor Annotation, (c) Causal Discover & Feedback Construction으로 구성되어 있다.

(a) factor Proposal

LLM Ψ 을 사용하여, 비정형 데이터를 통해서 factor 추출을 하기 위해서 COAT에서는 프롬프트 p와 데이터셋 D에서 추출된 샘플 데이터를 사용한다. (각 요소 w_k를 도출하고, 미리 정의된 값 공간으로 매핑 )

예: 비구조화 데이터를 기반으로 중요한 변수(예: "크기", "향", "맛")를 도출.

COAT는 아래 3가지 구성요소를 프롬프트로 구성해 LLM을 이용해 factor를 추출

Part 1: 고려 사항 (Consideration)

- LLM Ψ 이 고려해야 하는 과정을 자유롭게 작성:

각 요인은 구체적인 기준을 가지고 있으며, 값은 [−1,0,1] 중 하나

Part 2: 요인 필터링 (Factor filtration)

- 내용:

- 제안된 요인을 평가하여 사용할지 여부를 결정

- 평가 기준:

- 각 새로운 요인은 그룹을 구분하는 데 도움이 되어야 하며,

- 각 요인은 하나의 구체적인 측면에 집중해야 하며, 다른 요인과 중복되지 않아야 함.

Part 3: 최종 출력 (Final Output)

- 내용:

- 각 요인은 [−1,0,1]값을 가지며, 각 값에 대한 구체적인 기준을 제공

- 값 0에 대한 기준은 "그렇지 않거나 언급되지 않음"으로 고정

- LLM 출력 템플릿:

- Factor Name

- 1: [Positive Criterion]

- 0: [Otherwise; or not mentioned].

-1: [Negative Criterion] - 예시

영양 성분 (Nutritional Value)

- 1: 영양 성분이 풍부함.

- 0: 그렇지 않거나 언급되지 않음.

-1: 영양 성분이 부족함.

- Factor Name

이러한 방식을 통해서 V = {w_1,w_2,…,w_k} 추출과 비정형 데이터를 정형 데이터로 변경하는 기준을 결정하고 (w_1: 맛, w_2: 향) , 해당 기준을 통해서 라벨링 하는 단계로 이어진다.

(b) factor Annotation

LLM Ψ에서 추출된 factor에 대해서, 또 다른 LLM Ψs은 특정 기준에 따라 데이터를 라벨링한다. 라벨링이 완료된다면 한 요인 w_i에 대해, 모든 샘플 x_i에 대한 값을 z_i로 표현할 수 있다.

| 샘플 | w1 | w2 | w_k |

| 리뷰1 | -1 | 0 | 0 |

| 리뷰i | 2 | 1 | 0 |

모든 factor w_1,w_2,…,w_k에 대한 z_i를 모아 최종적으로 데이터 행렬 Z를 생성한다. 여기서 W는 t번째 라운드까지 LLM Ψ에서 제안된 w_i 변수의 집합이다. 데이터 행렬 Z≤t는 CD 알고리즘의 입력값으로 활용된다.

(c) Causal Discovery & Feedback Construnction

t 시점까지 추출된 Factor 를 활용해 도출된 데이터 행렬 Z와 후보 요인 W를 활용해, CD 알고리즘으로 인과 구조를 추론한다.

여기에서는 FCI 방식을 활용하여 인과 구조를 복구하였다. FCI를 활용한 이유는 입력 행렬 Z는 LLM으로 추출되었기 때문에 잠재적인 노이즈와 교란 요인을 허용하기 때문이다.

이렇게 t시점에 생성된 그래프 G_t를 활용하여, 새로운 프롬프트를 구성하여 LLM에게 새로운 샘플 D와 함께 Factor Proposal을 개선시키는 작업을 한다.

피드백을 생성할 때, 추가적으로 고민해야 하는 것은 LLM Ψ 에서 추출된 w_1, w_2,...w_k가 해당 데이터 샘플 D에서는 충분하지 않을 수 있고, 이를 추가적으로 식별하는 로직이 필요하다.

예를 들어, 사과 상품의 리뷰(X)와 평점(Y)을 설명하는데 요인 w1 맛과 w2 향만으로 충분하지 않은것은 당연하다. 따라서 추가적으로 w를 추가해야 하는데, 해당 논문에서는 Causal feedback이라는 과정을 통해서 w를 추가해야하는 기준을 설명한다.

만약에 t 시점까지 추출된 h(X)로 목표 변수 Y를 충분히 설명할 수 없다면, 비정형 데이터 X에는 Y와의 관계를 설명할 수 있는 숨겨진 변수 w가 존재한다는 의미이다. 즉, 새로운 변수 w를 추가한다면 엔트로피 H에서 아래 식이 성립한다.

따라서, 다음 라운드에서 LLM Ψ 은 아래 기준에 맞는 숨겨진 변수 w를 찾아야 하고, 이를 추출할 수 있는 데이터 샘플 D_t+1 을 선택해야 한다.

구체적으로는 아래와 같이 조건부 엔트로피 H(Y|h(X))가 높은 데이터 샘플 D_t+1을 식별하면 되며,

h≤t(X)를 기준으로 클러스터링하여 총 C개의 데이터 그룹 D를 얻는다. 이때 클러스터링은 K-means 클러스터링을 활용한다. 최종적으로는 조건부 엔트로피를 가지는 데이터 그룹 D를 선택하여 피드백(새로운 프롬프트 p_t와 D_t)을 구성하게 된다.

이러한 과정을 몇 라운드 반복해 w의 후보를 늘려가면서, Markov Blanket을 점진적으로 완성해간다. 위 긴 과정을 요약하면 아래와 같다.

- 피드백을 생성하여 다음 라운드로 전달

- 만약 요인이 부족하다면, COAT는 새로운 샘플을 선택하거나 프롬프트를 수정하여 LLM이 더 좋은 요인을 찾을 수 있도록 피드백을 생성

- 이 과정을 반복

- 새로운 요인이 추가되면서 Markov Blanket이 점진적으로 확장

COAT는CD 알고리즘(FCI)이 LLM을 통해 구성된 데이터셋을 통해 인과 그래프를 복구한다. 이때 활용하는 FCI에서는 faithfulness assumption 가정이 필요하기 때문에, LLM이 주석한 데이터가 높은 정확도를 가지고 있어야 하며 노이즈가 없어야 한다. 또한, 새로운 요인을 찾아내었을 때 너무 비슷한 정보를 추가하면 의미가 없기 때문에 LLM이 추출한 요인 w가 CD를 수행하는데 도움이 되는지 평가해야 한다.

해당 논문에서는 LLM마다의 Factor identification 능력을 측정하기 위해서 Capacity Score,

1. 용량 점수 (Capacity Score, ): LLM이 제안한 요인의 품질이 얼마나 좋은가에 대한 내용이며, Markov Blanket에 기여하는 정도이다. 이는 LLM에서 추출된 새로운 요인 w_k+1이 얼마나 큰 정보량 감소를 가져오는지 측정한다.

아래에서 I(Y;X∣h[k](X)는 현재 요인이고, h[k+1](X)는 새로운 요인 w_k+1를 추가하였을 때의 정보량이다.

- 가 높다 → LLM이 제안한 요인이 기존보다 훨씬 유용한 정보를 제공함.

- 가 낮다 → 새 요인이 기존과 거의 동일하거나 불필요한 정보일 가능성이 큼.

2. 인식 점수(perception Score, p): LLM이 프롬프트와 피드백에 얼마나 잘 반응하는가, LLM이 피드백과 입력 데이터를 바탕으로 올바른 요인을 제안할 수 있는지를 확인하기 위해 proposition 2.2에 부합하는 요인의 비율을 측정한다.

- p가 높다→ LLM이 유효한 요인을 자주 제안함.

- 주어진 프롬프트와 피드백에 효과적으로 반응하고 있음을 의미.

- COAT 라운드가 반복될수록 Markov Blanket이 빠르게 확장될 가능성이 높음.

- p가 낮다 → LLM이 유효하지 않은 요인을 자주 제안하거나, 프롬프트와 피드백을 제대로 활용하지 못함.

- 는 LLM이 유효한 요인을 제안하는 빈도를 평가하고, CΨ는 새로 추가된 요인이 기존 요인보다 얼마나 더 나은 정보를 제공하는지 측정

- p와

아래는 사과 속성에 대한 벤치마크 데이터셋으로 해당 프레임워크를 측정한 결과

- META: LLM이 컨텍스트만 제공받고 요인을 제안하는 방식

- DATA: LM이 관찰 데이터를 추가로 제공받아 요인을 제안하지만, COAT의 피드백 모듈 없이 단일 라운드 실행

- MB: 목표 변수 Y의 Markov Blanket에 속하는 요인

- NMB: 데이터와 관련은 있지만 목표 변수 Y의 Markov Blanket에 속하지 않는 요인

- OT: 데이터와 무관한 예상치 못한 요인

- Recall, Precision, F1 스코어: 목표 변수 Y의 Markov Blanket을 얼마나 잘 탐지했는지 평가

- LLM의 Chain-of-Thought(CoT) 접근법은 데이터에서 고수준 요인을 인식하는 데 도움이 되지만, 여전히 불필요한 요인을 제안하는 경향이 있음 (NMB가 높음).

- COAT는 피드백 메커니즘을 통해 LLM이 더 정확하고 유효한 요인을 제안하도록 유도. 이는 MB(유효 요인) 값이 높아지고 NMB(불필요 요인)와 OT(관련 없는 요인)가 감소한 결과에서 확인 가능

정리

COAT는 인과 관계를 신뢰할 수 있게 복원할 수 있는가?

- LLM을 직접 활용하여 인과 관계를 추론하는 것과 비교했을 때, COAT는 인과 관계 복원 성능을 크게 향상

- COAT의 인과 피드백(causal feedback)이 시스템의 견고성을 향상시키는 데 효과적

다시 돌아와서, LLM이 인과적 메커니즘을 밝히는 데 어떻게 도움을 줄 수 있을까?

COAT는 LLM이 직접적으로 인과 관계를 추론하지는 않지만, 인과 발견을 위한 요인(factors)을 식별하는 데 기여할 수 있음.

(1) 비정형 데이터로 부터 요인 제안

- LLM은 가능성이 높은 후보 요인을 제안

예를 들어, LLM은 사전 지식을 통해 "크기", "향기", "색깔" 등의 관측 가능한 요인을 제안

(2) 피드백을 통한 점진적인 그래프 개선

- COAT 프레임워크 내에서 LLM은 매 라운드마다 피드백을 받아 요인 제안 성능을 향상

즉, LLM이 단순히 한 번의 요인 제안을 하는 것이 아니라, 점진적인 피드백을 통해 더 신뢰할 수 있는 인과적 메커니즘을 찾도록 유도 - 이 과정에서 LLM이 올바른 요인을 제안할 확률(p)과 정보량 감소 효과(CΨ)을 지속적으로 평가.

참고 자료

https://nips.cc/virtual/2024/poster/93175

NeurIPS Poster Discovery of the Hidden World with Large Language Models

Abstract: Revealing the underlying causal mechanisms in the real world is the key to the development of science. Despite the progress in the past decades, traditional causal discovery approaches (CDs) mainly rely on high-quality measured variables, usually

nips.cc

Liu, Chenxi, et al. "Discovery of the Hidden World with Large Language Models." arXiv preprint arXiv:2402.03941 (2024).

'논문 리뷰' 카테고리의 다른 글

| 3. Causality가 LLM이 직면한 문제를 해결하는 데 어떻게 도움이 될 수 있을까? (0) | 2025.02.04 |

|---|---|

| 1. LLM은 인과 관계를 이해하고 추론할 수 있을까? (4) | 2024.11.05 |