실무에서 LLM을 활용하다 보면 출력 형식 준수도와 씨름하는 일이 잦다. 예를 들어 명확한 출력 기준을 주고 0과 1로 분류하게 하거나 0~10 숫자 중 하나를 선택하도록 해도, 모델이 때때로 -1을 내거나 “긍정/부정”만 허용했는데 “중립”을 내는 경우가 발생한다. 이러한 준수도 문제는 LLM 기반 시스템의 신뢰성과 운영 안정성에 직접적인 영향을 주며, 단순 프롬프트 수정만으로는 통제하기 어렵다. 본 글은 프롬프트 설계가 LLM의 준수도(compliance)와 정확도(accuracy)에 미치는 영향을 체계적으로 평가한 연구를 요약한 것이다.

What's in a Prompt?: A Large-Scale Experiment to Assess the Impact of Prompt Design on the Compliance and Accuracy of LLM-Generated Text Annotations

https://ojs.aaai.org/index.php/ICWSM/article/view/35807

What's in a Prompt?: A Large-Scale Experiment to Assess the Impact of Prompt Design on the Compliance and Accuracy of LLM-Genera

ojs.aaai.org

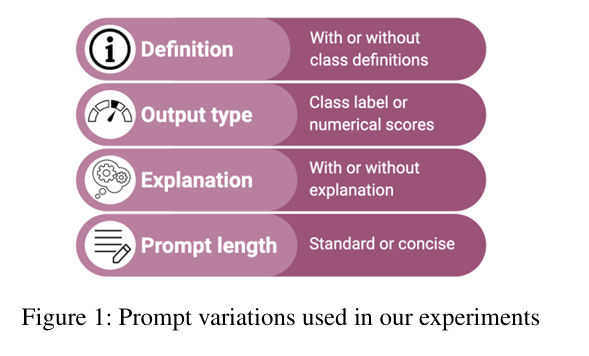

연구는 프롬프트 설계의 네 가지 축—정의 포함 여부, 출력 유형, 설명 요구, 프롬프트 길이—를 2×2×2×2로 구성하여 실험을 진행하였다. 출력 유형은 라벨(label)과 점수(score)를 비교하였고, 설명 요구는 예측 뒤에 간단한 근거를 서술하도록 하는지 여부를 가리켰으며, 프롬프트 길이는 상세한 표준형과 토큰을 줄인 간결형으로 대비시켰다.

- 프롬프트 요인(2×2×2×2)

① 라벨 정의 포함 여부(Definition: yes/no)

② 출력 타입(Label vs Score(확률/점수))

③ 설명 요구(Explanation: yes/no)

④ 길이(Standard vs Concise(간결))

모델은 GPT-4o, GPT-3.5-turbo-0613, PaLM2(chat-bison-001), Falcon-7B-Instruct를 사용하였으며, 모든 실험은 Temperature=0으로 고정하여 API 기반으로 수행하였다.

- 데이터셋 및 클래스 수

- 혐오표현 탐지: 3,480개 문장(2개 클래스)

- 감성 분류: 2,210개 문장(5개 클래스)

- 루머 스탠스 분류: 1,675개 문장(4개 클래스)

- 뉴스 프레임 탐지: 1,301개 문장(9개 클래스)

평가지표는 준수도와 정확도로 정의하였다. 준수도 (Compliance) 는 프롬프트 지시를 형식적으로 지켰는지의 여부를 뜻한다. 라벨을 출력하는 프롬프트에서는 허용 라벨 중 단 하나가 깔끔하게 파싱되면 준수로 간주하였고(e.g., 0 | 1), 다중 매칭이 발생하면 첫 번째 항목을 채택하였다. 점수를 출력하는 프롬프트에서는 [0,1] 범위의 실수를 라벨에 매핑한 뒤, 모든 점수의 합이 1±0.01이면 준수로 판단하였다. 정확도는 준수한 출력만을 대상으로 정확도(%)와 Macro-F1을 산출하였으며, 이는 형식부터 통과해야 품질을 잴 수 있다는 운영 현실을 반영한 방식이다.

준수도(Compliance)

- Label 프롬프트: 허용 라벨 중 단 하나가 깔끔히 파싱되면 준수(다중 매칭 시 첫 번째 채택).

- Score 프롬프트: [0,1] 범위 실수 추출 후 합계가 1±0.01이면 준수.

정확도(Accuracy)

- 준수한 출력만 대상으로 정확도(%)와 Macro-F1 산출

2. 프롬프트 실험 결과

2.1 정의 포함 (yes / no)

LLM의 최종 예측에 휴면 Annotation시에 활용한 정의를 포함

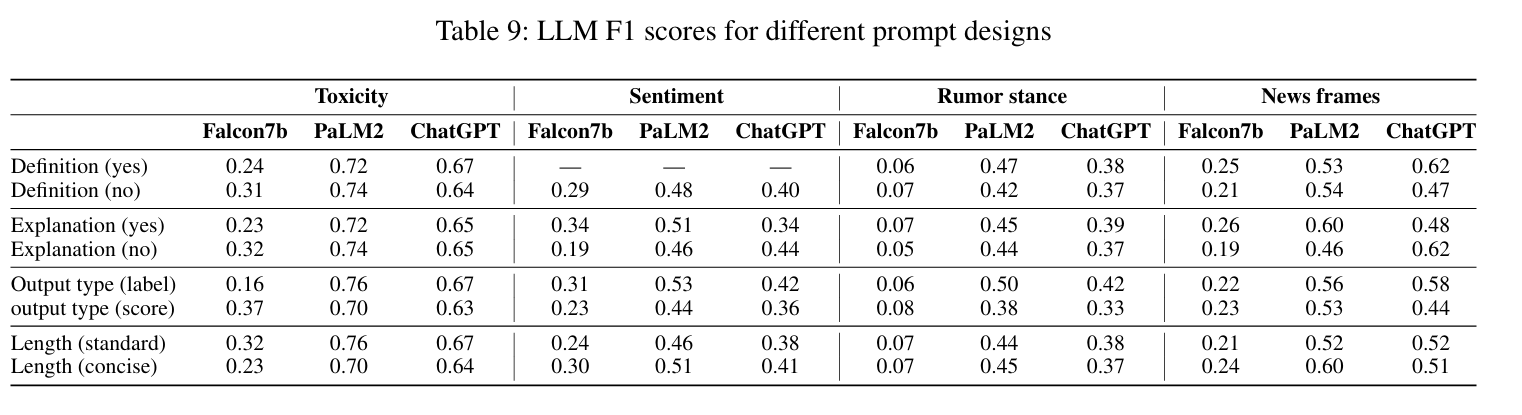

정의 포함 여부는 과제와 모델에 따라 상이한 효과를 보였다. 뉴스 프레임처럼 해석 폭이 넓은 과제에서는 GPT-4o, GPT-3.5, PaLM2의 정확도가 상승하는 경향이 확인되었다. 반면 PaLM2와 Falcon-7B는 다클래스 과제에서 지시의 복잡도가 높아지며 준수도가 하락하는 사례가 관찰되었다. 따라서 파라미터가 큰 모델에는 정의를 적극 포함하는 것이 유리하며, 소형·오픈모델에는 정의를 최소화하고 라벨 수를 축소하는 전략이 적합하다. 정의 제공은 독성, 루머 스탠스, 뉴스 프레임 과제에서 활용 가능하며, 감성 과제는 기존 데이터셋 구조상 별도의 정의가 없어 제외하는 것이 타당하다. 실무에서는 논문에서 인간 평가자에게 제공된 정의를 동일하게 사용하는 방식이 유효하다.

상세:

뉴스 프레임처럼 해석 폭이 넓은 과제에서 GPT-4o/3.5, PaLM2의 정확도↑

그러나 PaLM2·Falcon-7B는 (다클래스에서) 준수도↓—지시 복잡도 증가에 취약.

→ 파라미터가 많은 모델은 정의 적극 포함, 소형/오픈모델은 정의 최소화+라벨 수 축소 전략 병행

- 적용 과제: 독성·루머 입장·뉴스 프레임

- 제외 과제: 감성(기존 데이터셋에 정의가 없음)

- 활용 방법: 원 논문에서 인간 평가자에게 제공된 동일 정의 사용

2.2 출력 유형 (label / score)

LLM의 최종 예측을 ‘레이블’로 받을지, 각 레이블에 대한 ‘확률 점수’로 받을지에 대한 실험

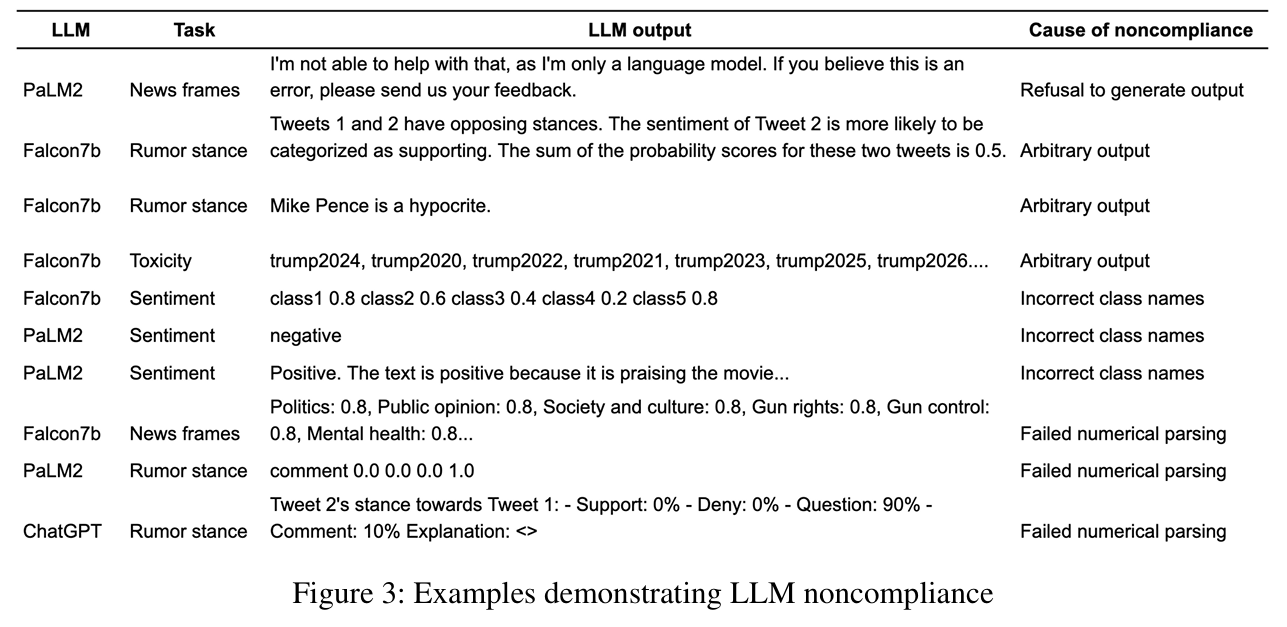

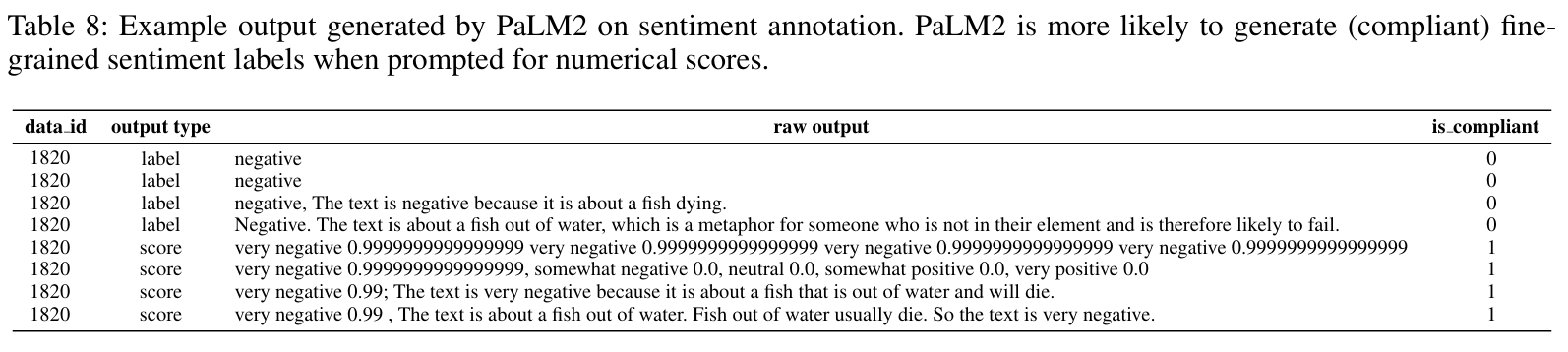

출력 유형에서는 라벨 대비 점수 출력을 요구할 때 다수의 모델과 과제에서 준수도와 정확도가 모두 낮아지는 경향이 관찰되었다. 전형적인 실패 패턴은 모든 라벨에 동일 점수를 부여하거나, 점수 합이 1을 초과하거나, 수치 형식을 어기는 경우였다. 예외적으로 Falcon-7B의 독성 과제에서는 소폭의 이득이 보고되었으나 일반화하기 어렵다. 따라서 비용 제어 또는 임계값 운용을 위해 점수 출력을 꼭 써야 한다면, 점수 합=1 검증, 소수 자릿수 제한, 균등 점수 탐지, 비준수 시 재요청 등의 강한 스키마 검증과 재시도 로직을 반드시 갖추어야 한다. 라벨 방식은 단순하고 후처리가 적다는 장점이 있으며, 점수 방식은 임계값 조정으로 정밀도·재현율 트레이드오프를 다루기 쉽다는 이점이 있다. 독성 필터링 임계값 선정과 같은 응용에서 점수 방식의 관리적 효용이 있을 수 있다는 점은 참고할 만하다.

상세:

라벨 대신 점수를 요구하면 준수도↓·정확도↓(대부분 모델·작업에서 동일 경향).

전형적 실패: 모든 라벨에 같은 점수, 점수 합>1, 형식 불일치 등 수치 규칙 위반.

예외: Falcon-7B의 독성에서만 미세한 이득.

→ 권고: 비용/운영 제어 필요로 Score를 쓸 땐 엄격한 스키마·합계검증·재시도 로직이 필수.

2.3 설명 (yes / no)

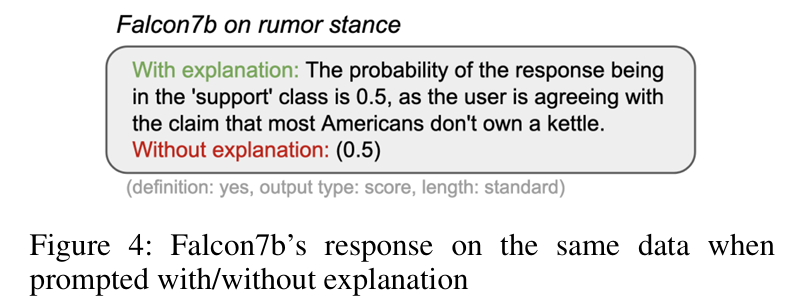

LLM이 예측 결과 뒤에 간단한 근거나 이유를 서술하는 것에 대한 실험

셋째, 설명 요구는 준수도에는 긍정적으로 작용하였으나 라벨 분포의 변형을 수반하는 위험이 있었다. 설명을 요구하면 잘못된 라벨 누락이나 허용되지 않은 라벨 응답이 줄어드는 경향이 있었고, 전반적으로 준수도는 상승하였다. 그러나 GPT-3.5의 감성 과제에서 ‘중립’ 라벨 비중이 19.68%에서 54.37%로 +34.69%p 증가하는 등 분포가 크게 이동하는 현상이 관찰되었고, Falcon-7B의 독성 과제에서는 ‘True(독성)’ 비중이 +13.17%p 증가하였다. 정확도 효과는 혼재적이어서 GPT-3.5의 감성·뉴스 프레임, Falcon-7B의 독성 과제에서 하락이 보고되었다. 따라서 설명은 감사·디버깅과 오류 패턴 분석에 유용하지만, 대규모 자동 라벨링 파이프라인에서는 분포 드리프트 감시와 무설명 모드 병행 검증이 필수이다. 설명을 요구하면 파싱 자동화가 복잡해지고 노이즈가 증가할 수 있다는 점도 고려해야 한다.

상세:

1. 설명을 요구하면 잘못된 레이블 누락, 허위 레이블 응답이 줄어드는 경향을 보임.

2. 설명을 요구하면 준수도는 대체로↑ 그러나 라벨 분포가 크게 이동함

GPT-3.5 감성에서 ‘중립’ 비중 +34.69%p(19.68% → 54.37%)

Falcon-7B 독성에서 ‘True(독성)’ +13.17%p

정확도는 혼재: GPT-3.5 감성·뉴스프레임 ↓, Falcon-7B 독성 ↓ 등.

→ 권고: 설명은 감사/디버깅에 유용하지만, 대규모 자동 라벨링 파이프라인에서는 분포 드리프트 감시와 무설명 모드 병행 검증 필요.

2.4 프롬프트 길이 (standard / concise)

상세 가이드라인을 담은 표준형과, 토큰 수를 약 40% 줄인 간결형과 비교

프롬프트 길이는 비용과 품질의 균형에 중요한 변수가 되었다. 간결형은 평균적으로 토큰을 크게 절감하였으며, GPT 계열에서는 준수도를 거의 해치지 않으면서 비용 절감 효과를 얻는 경우가 많았다. 감성 분류에서는 간결형으로 비용을 줄이면서 정확도를 동일하거나 오히려 높게 유지하는 사례가 관찰되었다. 반면 혐오표현 탐지처럼 민감하고 세밀한 지침이 필요한 과제에서는 간결형이 정확도 하락으로 이어지는 경향이 있었다. 따라서 단순한 과제에는 간결형을 적극 활용하고, 복잡·민감한 과제에는 표준형의 정교한 지침을 유지하는 것이 안전하다. 표준형은 DAIR·Akin 등에서 권장하는 서술적·상세한 방식과 부합하며, 간결형은 자동 요약 후 수작업 검증을 거치는 절차가 권장된다.

상세:

길이(Concise): 토큰 -54% 절감, 성능은 과제 의존

감성 분류: 간결한 프롬프트로 비용을 줄이면서 정확도는 동일하거나 ~상승함.

혐오 표현 탐지: 간결한 프롬프트가 정확도↓(모델 전반) — 세부 지침이 실제로 필요.

GPT-4o/3.5는 준수도는 거의 유지해 비용-품질 균형에 유리

즉, GPT 계열은 간결형 적극 활용 가능, 기타 모델은 주의

→ 권고: 단순한 과제=간결화, 복잡/민감한 과제=정교 프롬프트 유지

Reference:

Atreja, S., Ashkinaze, J., Li, L., Mendelsohn, J., & Hemphill, L. (2025). What’s in a Prompt?: A Large-Scale Experiment to Assess the Impact of Prompt Design on the Compliance and Accuracy of LLM-Generated Text Annotations. Proceedings of the International AAAI Conference on Web and Social Media, 19(1), 122-145.

'논문 리뷰' 카테고리의 다른 글

| 3. Causality가 LLM이 직면한 문제를 해결하는 데 어떻게 도움이 될 수 있을까? (0) | 2025.02.04 |

|---|---|

| 2. LLM이 인과적 메커니즘을 밝히는 데 어떻게 도움을 줄 수 있을까? (1) | 2025.01.30 |

| 1. LLM은 인과 관계를 이해하고 추론할 수 있을까? (4) | 2024.11.05 |